L’ensemble du personnel des deux laboratoire a été invité à envoyer ses plus jolies figures, qu’elles proviennent de publications récentes ou de vos travaux actuels, et de sélectionner celle qui conjugue au mieux à la fois intérêt scientifique et singularité esthétique. Un jury a délibéré et sélectionné 8 figures qui sont exposées dans l’Agora (espace entre ImViA et le LEAD, 3ème étage, I3M). Quatre prix ont également été décernés.

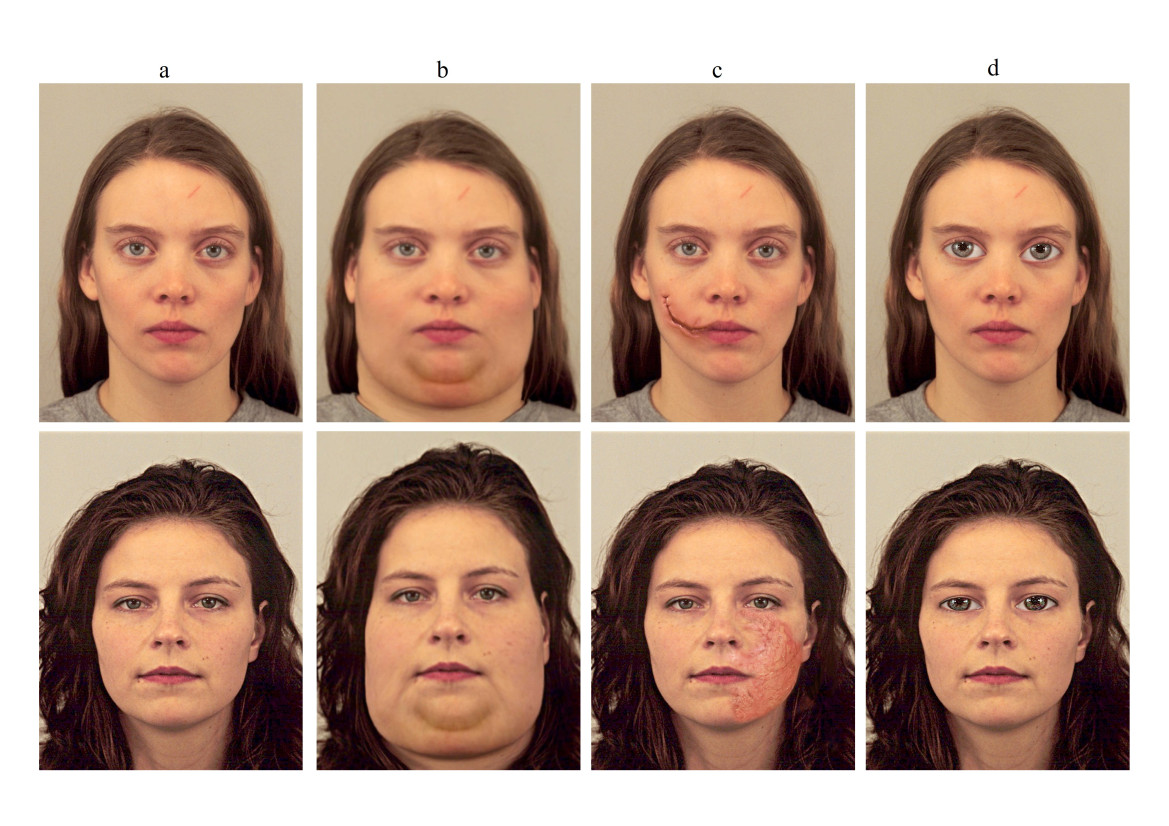

Gaëtan THIEBAUT, 2022 Le principe de ces expériences est d’associer des visages “normaux” ou des visages déviant de la normalité (soit un visage obèse, ou étrange avec les yeux élargis, ou porteur de cicatrices) avec des objets. Les participants devaient alors juger dans quelle mesure ils seraient mal à l’aise à l’idée de toucher l’objet en contact avec cette personne. Puis après quelques minutes, ils devaient rappeler les différents objets indépendamment des visages auxquels ils étaient associés.

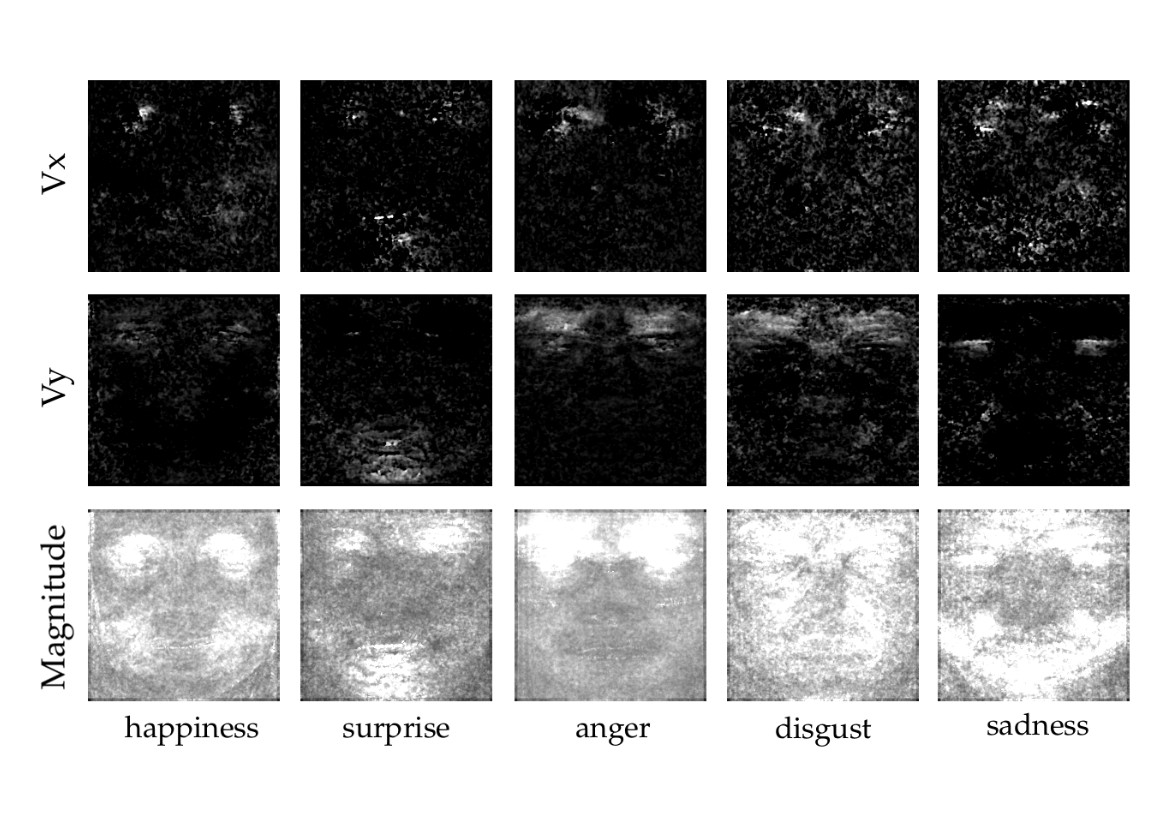

Reda BELAICHE Contrairement à une macro-expression, visible à l’œil, une micro-expression est un type d’expression faciale involontaire extrêmement rapide et de très faible intensité. Elle est universelle et ne dépend pas de la culture ou des origines. Reda Belaiche, Yu Liu, Cyrille Migniot, Dominique Ginhac and Fan Yang Cost-effective CNNs for real-time Micro-Expression recognition, Applied Sciences, MDPI, 2020

Hermine CHATOUX, 2022 This a synthetic color fractal image. The distribution of colors is similar at several scale. Fractals are common in nature (coast, cauliflower, etc.). Yet, to synthesize such an image you need knowledge in color science, signal processing and mathematics. where I(x) is the color of a pixel, x the location of a pixel and H∈]0,1[ relates to the complexity of the fractal. The higher H, the less complex the image.

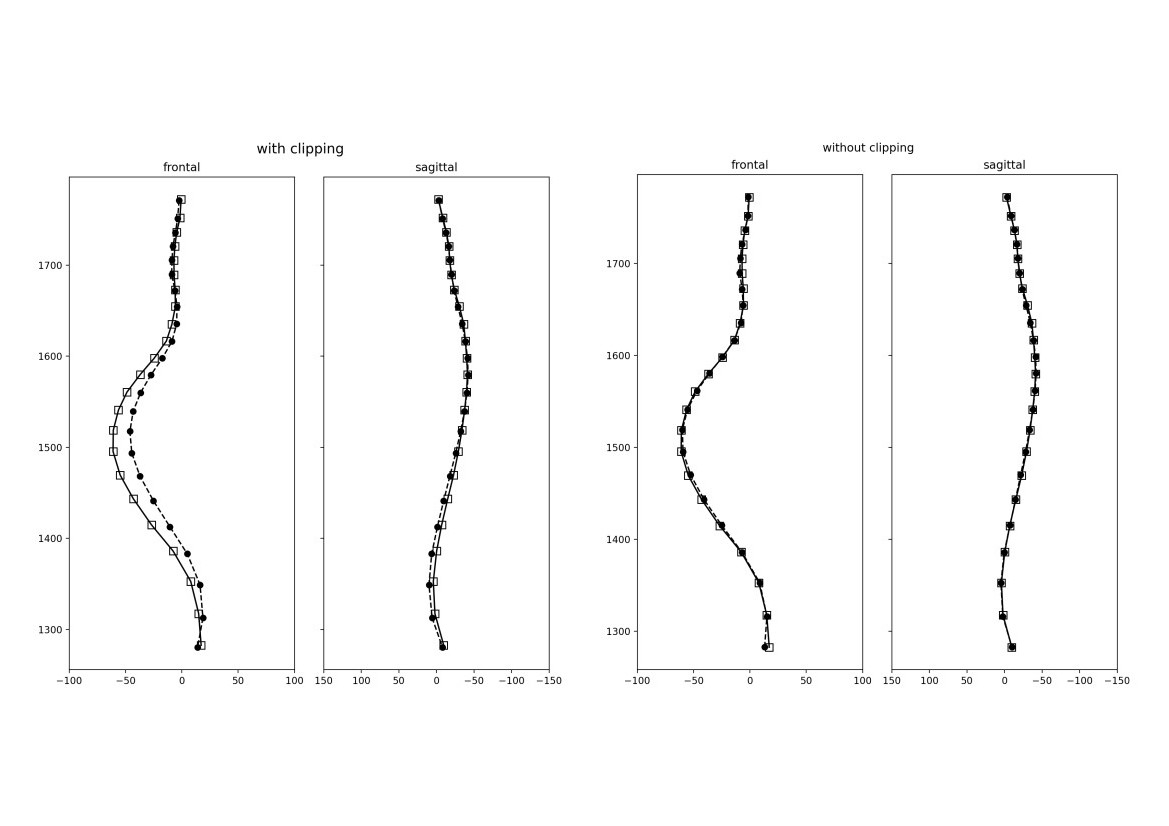

Manon ANSART, 2021 This 3D spine reconstruction method from 2D images constrains the model to smooth spine shapes well represented in the training population. On the left, the previous method leads to poor reconstruction performance for patients with unusual scoliosis. On the right, our proposed method achieves better performance while constraining the results to smooth spine shapes. True spine: squares (vertebral centers) and dashed lines. Reconstruction: dots (vertebral centers) and plain lines. SPIE Medical Imaging, 2022

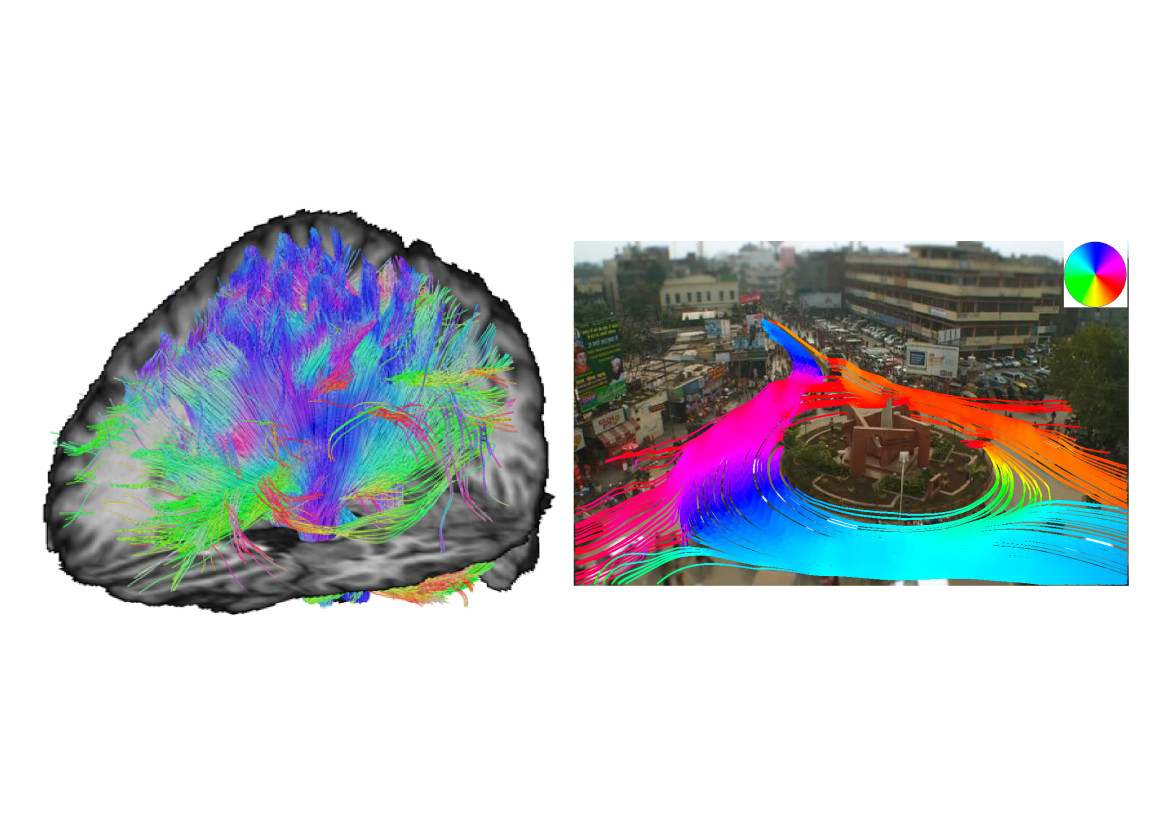

Yannick BENEZETH, 2013 Illustration d’une méthode pouvant extraire des modèles de mouvements dominants et les principales zones d’entrée/sortie d’une scène par analyse vidéo. La méthode calcule d’abord les histogrammes de mouvement pour chaque pixel, puis les convertit en fonctions de distribution d’orientation (ODF). À partir de ces ODF, une procédure de meta-tracking de particules est utilisée, qui produit des meta-tracks, c’est-à-dire des trajectoires de particules. Contrairement au suivi conventionnel qui se concentre sur les objets mobiles, le meta-tracking utilise les particules pour suivre le flux dominant du trafic. Ces meta-tracks sont ensuite utilisés pour identifier les mouvements dominants et les principales zones d’entrée/sortie de la scène. Ce type de suivi s’inspire de la tractographie des fibres cérébrales qui est utilisée depuis longtemps pour trouver les connexions dominantes dans le cerveau. P.-M. Jodoin, Y. Benezeth, Y. Wang, Meta-Tracking for Video Scene Understanding, IEEE Int. Conf. on Advanced Video and Signal-Based Surveillance (AVSS), 2013

Alessandro CARLINI, 2018 Notre perception visuelle du mouvement est influencée par le son. Carlini, A., & Bigand, E. (2021). Does Sound Influence Perceived Duration of Visual Motion?. Frontiers in Psychology, 12.

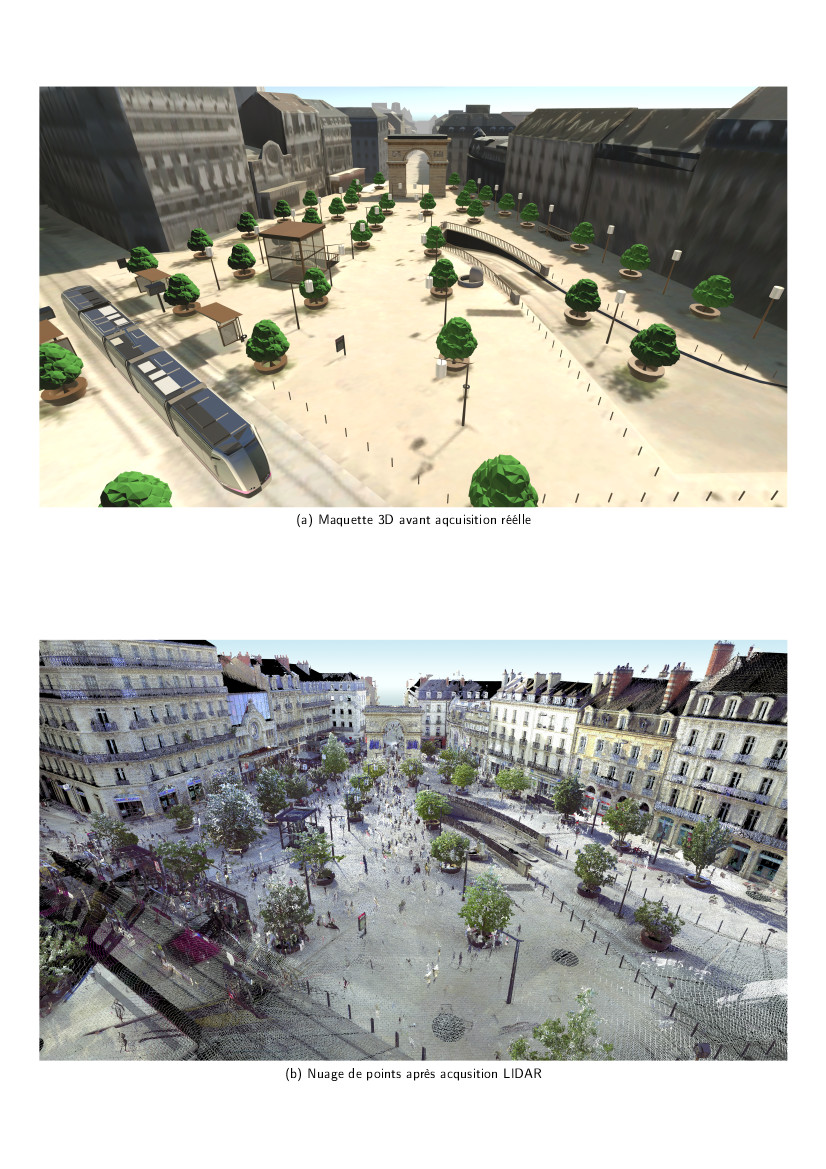

Stéphane Stéphane ARGON, Camille BORDEAU, Maxime AMBARD, 2022 Maquette 3D d’après plans GéoBFC* puis scan Lidar de la place Darcy à Dijon permettant d’obtenir un modèle 3D texturé précis. * Plateforme géomatique Bourgogne Franche-Comté

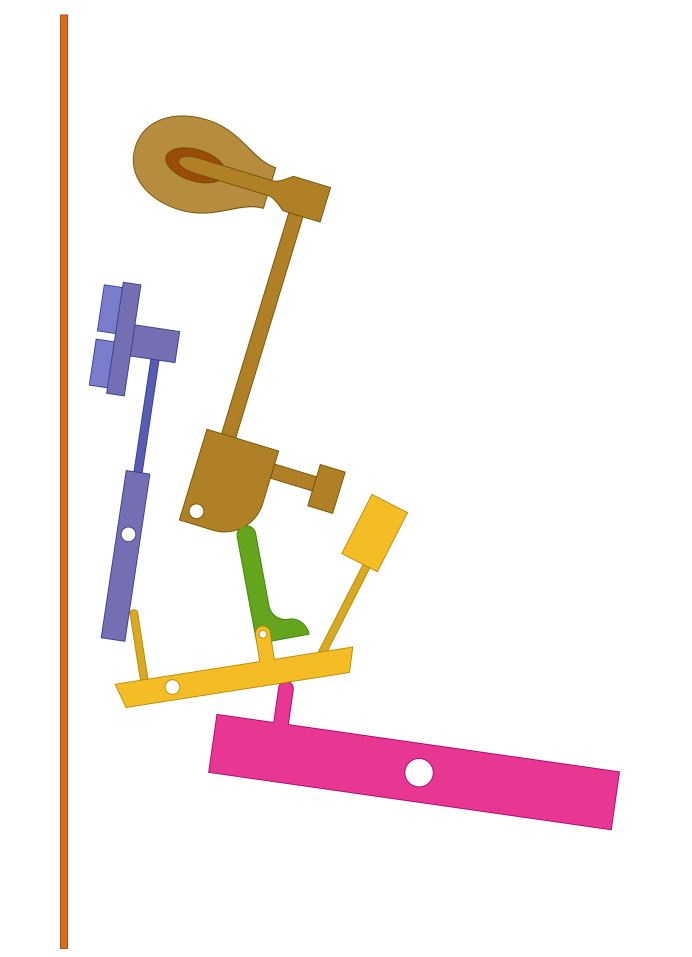

Stéphane ARGON / Jean-Michel BOUCHEIX, 2004 Conception d’animation pour l’aide à la compréhension de mécanismes complexes en pédagogie.

Visages modifiés sous logiciels et utilisés lors de trois expériences en mémoire

Support : Gimp, Fatify, FaceApp

La littérature montre que nous retenons mieux les objets associés à des visages malades et contagieux (Bonin et al., 2019). De tels résultats seront-ils observables pour des visages rappelant la maladie sans pour autant être contagieux ?Chouette d’Or Récompense la figure avec une problématique scientifique claire et une bonne esthétique

Mouvement moyen du visage lors d’une micro-expression

Support : Matlab

Le flot optique est calculé entre le début (onset) et l’instant d’intensité maximale (apex) de la micro-expression pour représenter le mouvement réalisé entre ces deux instants.

Cette image représente la moyenne du flot optique calculée par type de micro-expression sur les bases de données publiques CASME II et SAMM.Prix Tengmalm: Met à l’honneur la figure qui avait toute ses chances pour obtenir le premier prix.

Synthesized color fractal images

Support : python

These images are based on the Fractional Brownian motion that correlates the color variance with the spatial distance:

The images are generated in the CIELAB color space to ensure a perceptual color difference linked to the Euclidean distance. The synthesis is released on the spectral domain using the quaternion Fourier transform as a key element to the generation.Prix Hulotte: Récompense la figure la plus jolie, qui se suffit a elle même en tant qu’objet esthétique.

Improvement of a 2D to 3D spine reconstruction method – example of a patient with unusual scoliosis

Support : matplotlib, PythonPrix Effraie: Récompense la figure dont le sujet de l’étude est particulièrement explicite et parlant.

Tractographie des fibres cérébrales appliquée à l’analyse vidéo

La meilleure perception du mouvement : avec le son plus complexe

Support : matlab, excel

La figure montre l’erreur commise dans l’estimation de la durée d’un mouvement simple observé sur un écran, auquel sont associés différents sons. L’axe horizontal propose les 9 conditions sonores possibles, en commençant par l’absence de son (« Silent », à gauche), puis des sons constants (440, 660, 880 Hz), les rampes croissantes et décroissantes (UP et DW), la complexité croissante jusqu’à la condition la plus complexe « S_BIO » (à droite). Avec cette dernière condition, notre capacité à estimer la durée est la meilleure (le marqueur est le plus petit : accuracy maximale, et celui avec la plus petite valeur en ordonnée : précision maximale).3D Sound Glasses – Réalisation d’un environnement de substitution vision-audition immersif VR.

Support : Autodesk 3ds Max, FARO Focus3D, Autodesk ReCap

Ce modèle 3D nous servira à étudier les capacités de déplacements pédestres de personnes non-voyantes dans un environnement urbain grâce à un guidage sonore.Simulation du mécanisme de piano droit

Support : Adobe Flash, Adobe Director

L’étude évalue le degré de compréhension du mécanisme en comparant différents modes de présentation de l’animation du piano.

Utilisation de l’oculomètre (eye tracker) pour analyser les stratégies d’apprentissage.

- kc_data:

- a:8:{i:0;s:0:"";s:4:"mode";s:2:"kc";s:3:"css";s:0:"";s:9:"max_width";s:0:"";s:7:"classes";s:0:"";s:9:"thumbnail";s:0:"";s:9:"collapsed";s:0:"";s:9:"optimized";s:0:"";}

- kc_raw_content: