Fiche de MIGNIOT Cyrille

| Adresse | 9 avenue Alain Savary - BP47870 - 21078 DIJON |

| Localisation | Bâtiment I3M - Bureau 315 |

| Tél. | 03 80 39 36 92 |

| cyrille.migniot@u-bourgogne.fr |

- Recherches

- Enseignements

- Publications

- Encadrements

- Évennements

Système sonore d’aide à la locomotion des déficients visuels

Il s’agit du projet région envergure 3DSG en collaboration avec le laboratoire LEAD qui à développer des lunettes électroniques permettant d’aider les personnes non-voyantes à éviter les obstacles lorsqu’elles se déplacent à pied. Ce système est basé sur une technologie qui convertit l’information visuo-spatiale collectée en trois dimensions par une caméra temps-de-vol ou stéréoscopique en un flux sonore spatialisé grâce à une méthode dite de substitution sensorielle. Les 3 dimensions visuo-spatiales (droite-gauche, bas-haut et éloigné-rapproché) sont traduites par les indices auditifs (oreille droite-oreille gauche, grave-aiguë, son plat-son percussif). Le traitement de l’information qui convertit le flux vidéo acquis par une caméra temps-de-vol ou caméra stéréoscopique en un flux sonore spatialisé se fait en deux temps. Tout d’abord, le flux vidéo brut provenant de la caméra est filtré pour ne conserver que les éléments graphiques que l’on souhaite retenir. Une fois le flux vidéo simplifié, il doit être transformé lors d’une seconde étape en un flux sonore stéréophonique. Pour cela, nous associons chaque pixel graphique conservé lors de la première étape avec un pixel sonore.

Partenaires : Maxime Ambard, Julien Dubois, Florian Scalvini

Publications : ICASSP2022 – SITIS2022

Micro-expressions et reconnaissance d’émotions

L’informatique affective consiste à concevoir et à développer des systèmes pouvant reconnaître, interpréter, analyser et synthétiser les affects humains (sentiment, humeur, émotion et sensation). Cette branche moderne de l’informatique permet d’analyser les états émotionnels d’une personne et de fournir une réponse adaptée et appropriée de la part de l’interface homme machine. Basée sur les techniques de vision par ordinateur, l’objectif de ce projet est d’établir un système de reconnaissance des émotions sans contact et temps réel. Il devra respecter plusieurs des contraintes générales liées aux applications grand-public : robustesse et flexibilité, faible coût, usage simple et capacité à être embarqué à moindre coût énergétique. Dans un premier temps, une caméra rapide sera utilisée pour la capture des micro-expressions. Une nouvelle base de données sera créée dans des conditions réelles d’interaction homme/machine. Ensuite, des algorithmes déjà existants de reconnaissance des macro-expressions seront testés puis améliorés sur des images/vidéos sélectionnées afin de les généraliser au cas des micro-expressions. Certaines nouvelles approches spécifiques à l’analyse des micro-expressions et utilisant des techniques de Machine Learning seront étudiées et proposées.

Partenaires : Fan Yang, Reda Belaiche, Dominique Ginhac, Yannick Benezeth, Rita Meziati Sabour

Publications : Applied Sciences 20 – ICIAP19 – SITIS19

Analyse de démarches

L’analyse du mouvement humain est un sujet primordial notamment dans le domaine médical. Pour une analyse pertinente, il faut étudier la déformation locale du corps au cours du temps. C’est à ce niveau de précision qu’une anomalie peut-être détectée ou qu’une guérison peut être appréciée. Pour une représentation efficace du corps, les données 3D sont préférables. En effet elles forment une représentation très représentative et descriptive des formes humaines. Elles ont de plus l’avantage de ne pas être perturbées par la couleur ou les imperfections de la peau. Ces données sur le corps de la personne peuvent prendre la forme d’un nuage de points 3D. La déformation du corps est alors obtenue par un suivi du nuage de points qui détermine l’évolution temporelle du nuage.

Le projet a été réalisé en collaboration avec la société Proteor, spécialisée dans la fourniture d’appareillage de rééducation (corsets et prothèses). L’objectif de ce travail est de fournir un outil permettant d’analyser l’effet d’une prothèse (ou d’un corset).. Un classifieur a été mis en place pour reconnaître une démarche pathologique. La reconnaissance est effectuée à partir d’un LSTM sur les angles de flexion des jambes. Les principales contributions sont la création d’une nouvelle base de données de démarches à partir d’une caméra kinect (données de couleur, de profondeur et squelette), puis l’introduction de nouvelles caractéristiques descriptives du mouvement et enfin la mise en place d’un classifieur LSTM utilisant ces caractéristiques pour la reconnaissance de cas pathologiques.

Partenaires : Albert Dipanda et Margarita Khokhlova.

Publications : AIM19 – MTAP18 – SITIS18 – VISAPP18 – SITIS16

Héritage culturel et réalité virtuelle

De nos jours les outils informatiques ont considérablement augmenté le besoin de conservation et de distribution de notre héritage culturel. Chaque œuvre artistique, chaque trace de notre passé est enregistrée afin d’en assurer la pérennité et de la rendre accessible à chacun. De plus l’utilisation courante de technologies avancées a rendu le public exigeant sur la qualité des données qui lui sont fournies et de nouveaux supports pédagogiques pour l’enseignement ont été introduits. Il est à noter que les artistes eux même se sont rendus compte du potentiel de l’informatique et produisent des œuvres à partir de systèmes numériques comme des caméras haute résolution ou même des téléphones portables. Il convient de définir des outils pour rendre l’accès à ces données ludique, agréable et original. Cela par exemple par un accès aux parties des œuvres habituellement cachées, par la reconstruction de parties manquantes ou par l’utilisation de la réalité virtuelle. Ces outils seront destinés à la fois au grand public, aux spécialistes et aux chercheurs.

Pour permettre un accès ludique et agréable aux œuvres, la représentation virtuelle est un outil précieux. En effet celle-ci sera accessible quel que soit l’endroit où l’usager se trouve et ce dernier pourra la manipuler sans crainte de dégrader une œuvre inestimable et unique. Les techniques actuelles d’acquisition permettent d’obtenir aisément une représentation 3D de grande qualité de n’importe quel objet. Le problème est alors de permettre une interaction stimulante entre l’utilisateur et la représentation 3D.

Partenaires : Albert Dipanda et Ammar Ahmad.

Publications : IVC19 – SITIS17 – CH15

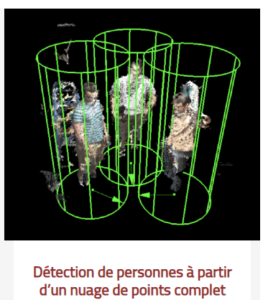

Détéction 3D

La reconstruction tridimensionnelle à partir de séquences vidéo multi-caméra pour l’analyse ou le suivi du mouvement de personnages ou plus généralement d’objets déformables en temps réel et sans marqueur est un sujet d’une grande actualité au sein de la communauté internationale du domaine de par de nombreuses applications présentes et surtout à venir. L’objectif de du projet RAHA est la mise en place d’une plate-forme d’acquisition d’images permettant la reconstruction 3D et l’analyse du mouvement temps réel d’un sujet déformable. L’acquisition est réalisée à partir d’un ensemble de plusieurs Kinects disposées de façon à obtenir une vision 3D selon une vue à 360°. Nous avons mis en place une méthode de détection de personnes à partir de ces données. Le processus de descripteur HOG est modifié pour ce dessein. La normale de chaque point 3D de l’acquisition donne une bonne vision de la forme de l’enveloppe d’une personne; elle remplace le gradient dans notre descripteur. La quantification de l’orientation 3D pour le calcul des histogrammes est réalisé par projection des normales sur les faces d’un polyèdre régulier.

Partenaires : Albert Dipanda et Kyis Essmaeel.

Publications : MTAP19 – VISAPP16 – ORASIS15

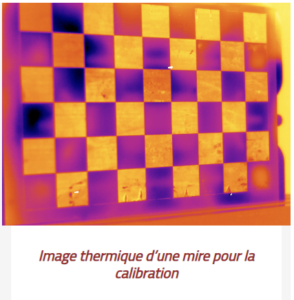

Estimation du mouvement par thermographie infrarouge

Le contrôle non destructif de matériaux peut se réaliser par le biais de la thermographie infrarouge. En soumettant l’élément à contrôler à une excitation extérieure maitrisée et en analysant la propagation de la chaleur dans la zone examinée, il est possible de mettre en évidence des défauts surfaciques ou su surfaciques telles que des fissures, des délaminages ou de la corrosion. L’excitation locale du matériau par une source laser apparaît comme une approche pertinente en terme de localisation de défaut ou de caractérisation de matériaux anisotropes.

L’objectif de se travail est de concevoir un système de contrôle non destructif par thermographie active mobile. Le travail porte sur la détermination du mouvement relatif du capteur par rapport à des ‘marqueurs thermiques’ sur l’objet observé.

Partenaires : Olivier Aubreton et Thomas Herrmann

UFR Sciences et Techniques

UFR Sciences et Techniques

M2 – Traitement numérique des vidéos

M1 – Réseaux

M1 – Traitement des images

L3 – Systèmes et Réseaux

- CM – slides

- TD – sujet

- TP – sujet – compteRenduTP1 – compteRenduTP2 – compteRenduTP3 – Cyrano.txt

- Examens – 2018 – 2019 – 2020

L1 – Programmation HTML

L1R – Informatique

GEIPI 1A – Programmation C

- CM – slides

- Sujet TD – TD1-2 TD3-4 TD5-6 TD7 TD8-9 TD10

- Sujet TP – TP1 TP2-3 TP4 TP5 TP6-7 TP8

- Examens – octobre2016 – decembre2016 – octobre2017 – decembre2017 – janvier2018 – novembre2018 – decembre2018 – janvier2019 – novembre2019 – decembre2019 – janvier2020

- Exercices bonus : binaire – Fibonacci – jeu de dé – Tabou – Yams – Zombies

PUBLICATIONS HAL

Doctorants

Chen XIANGMEI

Titre : Prédiction des performances de la communication acoustique sous-marine basée sur l’apprentissage automatique

Sujet : La transmission de liaison fiable des réseaux acoustiques sous-marins à longue portée est confrontée à de graves défis physiques, ce qui entraîne une série de difficultés pour la conception de liaisons fiables : i.L’environnement du canal acoustique sous-marin est complexe et dynamique : les conditions de propagation acoustique à longue portée le canal acoustique sous-marin a de grandes fluctuations et la plage de fluctuation peut atteindre 10 ~ 20 dB. Les conditions de rapport signal sur bruit de communication à différentes distances sont souvent très différentes. L’environnement complexe des canaux acoustiques sous-marins oblige à donner la priorité à la fluctuation des performances de communication dans la conception des liaisons. ii.La bande passante disponible du canal acoustique sous-marin est très étroite : à partir de la formule de perte de propagation, on peut voir que la perte de propagation est proportionnelle au coefficient d’absorption, et le coefficient d’absorption est positivement lié à la fréquence et à la distance de propagation du acoustique, c’est-à-dire que plus la fréquence et la distance de propagation de l’onde acoustique sont élevées, plus le coefficient d’absorption est élevé et plus la perte de propagation est importante. Par conséquent, seuls les signaux acoustiques à basse fréquence sont applicables dans la communication acoustique sous-marine à longue portée, c’est-à-dire que la bande passante disponible du canal acoustique sous-marin est sévèrement limitée. La bande passante disponible très limitée pose un problème critique à la conception de la liaison : l’exigence d’utilisation du spectre est très élevée.

Co-encadré avec : Fan Yang

Thèse commencée le : 21 décembre 2022

Quentin HÉRAU

Titre : Cartographie compressée et évolutive pour la navigation à long terme sur support embarqué à partir de données provenant de sources multiples

Sujet :Le sujet principal de ce doctorat porte sur l’amélioration de la cartographie embarquée pour la localisation à long terme dans un environnement dynamique en utilisant des données issues de sources diverses. La localisation et la cartographie sont des éléments fondamentaux pour permettre une conduite autonome sûre et des capacités d’automatisation avancées pour les véhicules de demain. Cependant, une cartographie précise est coûteuse tant par la résolution temporelle et la qualité des données requises. D’une part, les données cartographiques doivent avoir une résolution temporelle élevée : afin de maintenir la carte à jour, les données doivent être collectées fréquemment pour prendre en compte les modifications dynamiques de l’environnement. D’autre part, une cartographie précise nécessite des données de qualité : les systèmes de cartographie mobiles existant s’appuient sur une myriade de capteurs aux modalités différentes et complémentaire. Ce constat nous mène à la conclusion suivante : la cartographie à long terme et sur de larges zones nécessaire au déploiement de véhicule autonomes en utilisant les solutions d’acquisition mobiles existante n’est pas une solution viable car trop couteuse.

Une solution attrayante consiste à utiliser des données dites « crowd-sourced » ; issues de sources multiples et décentralisées, qui ont l’avantage d’avoir une grande résolution temporelle mais une qualité inférieure à celle des données obtenues à partir d’une plateforme d’acquisition spécifique plus coûteuse. La redondance des données « crowd-sourced » permet de capturer la dynamique de l’environnement pour mettre à jour la représentation cartographique utilisée par les algorithmes de localisation d’un véhicule autonome. L’analyse temporelle de ces données offre la possibilité de prédire les changements susceptibles de se produire et de distinguer les changements permanents des modifications structurelles temporaires. En utilisant des méthodes d’analyses centrées sur la donnée et avec des volumes d’information suffisants, la détection de ces changements pourra émerger directement des données de cartographie et permettra de prédire des comportements au-delà d’une nomenclature prédéfinie.

Afin de partager les informations provenant de sources diverses et décentralisées, les données acquises par un système embarqué doivent être compressées ou prétraitées à bord du système d’acquisition. Ceci implique deux contraintes distinctes : le traitement embarqué des données issues des capteurs ainsi que la compression des données cartographiques issues de ce traitement. Pour subvenir à la contrainte de l’embarqué, l’emploie d’algorithmes de cartographie légers pouvant être exécutés sur des dispositifs à faible capacité de calcul est à préconiser. Afin de réduire la quantité d’information devant être partagée, les données cartographique peuvent être filtrées en amont afin conserver seulement les caractéristiques cartographiques significatives pour des applications ciblées, telles que la localisation d’un véhicule à partir d’une carte.

La qualification de la qualité des cartes est également un aspect important pour un fournisseur de services de localisation, tel que celui utilisé dans une voiture autonome. En analysant la qualité et la densité des données traitées, un autodiagnostic peut offrir une qualification fine de la zone cartographiée. Une telle qualification permet de demander de manière proactive de nouvelles données sur une zone spécifique afin de maintenir le niveau de qualité cartographique requis pour faire fonctionner un véhicule autonome en toute sécurité.

Co-encadré avec : Cédric Demonceaux, Nathan Piasco et Pascal Vasseur

Thèse commencée le : 17 mars 2022

Florian SCALVINI

Titre : Développement de lunettes électroniques servant de système sonore d’aide à la locomotion des déficients visuels

Sujet : Le projet 3D Sound Glasses consiste à développer des lunettes électroniques permettant d’aider les personnes non-voyantes à éviter les obstacles lorsqu’elles se déplacent à pied. Ce système est basé sur une technologie qui convertit l’information visuo-spatiale collectée en trois dimensions par une caméra temps-de-vol ou stéréoscopique en un flux sonore spatialisé grâce à une méthode dite de substitution sensorielle.Le traitement de l’information qui convertit le flux vidéo acquis par une caméra temps-de-vol ou caméra stéréoscopique en un flux sonore spatialisé se fait en deux temps. Tout d’abord, le flux vidéo brut provenant de la caméra est filtré pour ne conserver que les éléments graphiques que l’on souhaite retenir. Une fois le flux vidéo simplifié, il doit être transformé lors d’une seconde étape en un flux sonore stéréophonique. Pour cela, nous associons chaque pixel graphique conservé lors de la première étape avec un pixel sonore. Pour que le système mobile soit pleinement opérationnel (autonomie, encombrement, température, réactivité) il est nécessaire que les algorithmes soient implémentés sur des cibles matérielles permettant le temps réel (par exemple FPGA ou GPU).

Co-encadré avec : Julien Dubois et Maxime Ambard

Thèse commencée le : 1er novembre 2020

Reda BELAICHE

Titre : Étude des émotions par l’analyse temps-réel des micro-expressions basée sur la vision par ordinateur

Sujet : Basée sur les techniques de vision par ordinateur, l’objectif de cette thèse est d’établir un système de reconnaissance des émotions sans contact et tempsréel. Il devra respecter plusieurs des contraintes générales liées aux applications grand-public : robustesse et flexibilité, faible coût, usage simple et capacité à être embarqué à moindre coût énergétique. Le rendu des émotions par les expressions faciales n’est pas culturelle mais universelle. Ainsi, les émotions de base sont généralement réparties en six catégories. Récemment ces expressions ont également été divisées en deux classes : les macro et les micro-expressions. Les micro-expressions se produisent sur une durée comprise entre 1/4 et 1/25 de seconde. Elles sont involontaires et révèlent les véritables émotions de la personne. Cependant, la localisation et l’analyse de ces événements sont très compliquées du fait de leur faible durée et de leur faible intensité.

Co-encadré avec : Fan Yang et Dominique Ginhac

Thèse soutenue le : 30 septembre 2022

Thomas HERRMANN

Titre : Contrôle Non Destructif par thermographie active dynamique

Sujet : L’objectif de la thèse est de concevoir un système de contrôle non destructif par thermographie active mobile. Pour ce faire le travail porte sur la détermination du mouvement relatif du capteur par rapport à des ‘marqueurs thermiques’ sur l’objet observé. L’acquisition sera réalisée à l’aide d’un capteur infrarouge et d’un capteur RGB-D. On étudiera aussi l’observabilité de ces marqueurs pour définir plusieurs paramètres comme leur fréquence de régénération.

Co-encadré avec : Olivier Aubreton

Thèse commencée le : 1 octobre 2017

Ammar AHMAD

Titre : Manipulation virtuelle des représentations 3D d’objets culturels

Sujet : Une tendance croissante consiste à étudier la Réalité Virtuelle (RV) au service du patrimoine culturel. Les plus grands musées du monde proposent aujourd’hui à leurs visiteurs différents outils de réalité virtuelle ou augmentée pour une expérience culturelle enrichie. Dans une visite classique d’un musée, les objets culturels exposés ne sont pas accessibles. Les visiteurs ne peuvent pas les toucher ni les manipuler. L’un des apports de la RV est d’offrir une dimension supplémentaire d’interactivité : les visiteurs deviennent des acteurs placés au centre de l’expérimentation virtuelle et capables d’interagir avec les différentes entités culturelles composant l’univers simulé. Notre projet a pour cadre l’interaction 3D avancée au service des musées du futur. Sa finalité est de permettre aux visiteurs d’un musée une activité sensori-motrice dans un environnement virtuel ou augmenté : manipuler la maquette numérique d’objets culturels exposés. Le but est donc de suivre les interactions 3D entre les mains d’un visiteur évoluant dans le monde réel et des objets culturels 3D évoluant dans un monde virtuel. Le suivi visuel sans marqueur des mouvements de la main est un élément clé et populaire des études d’interaction dans de nombreux domaines tels que la réalité virtuelle et les interfaces naturelles homme-ordinateur. Bien que ce domaine de recherche ait été bien étudié au cours des dernières décennies, la plupart des approches ont considéré la main humaine en isolation et non pas en action ou en interaction avec l’environnement ou les autres parties articulées du corps humain. L’utilisation d’information contextuelle sur l’environnement (par exemple, la forme, la texture et la posture de l’objet dans la main) peut contraindre considérablement le problème de suivi. Les contraintes contextuelles les plus étudiées impliquent interaction avec des objets réels et non pas avec des objets virtuels qui reste tout un défi. Le suivi des mains manipulant des objets virtuels semble donc être une avenue de recherche particulièrement prometteuse.

Co-encadré avec : Albert Dipanda

Thèse commencée le : 7 octobre 2015

Margarita KHOKHLOVA

Titre : Évaluation clinique de la démarche à partir de données 3D

Sujet : L’analyse de la démarche clinique est généralement subjective, étant effectuée par des cliniciens observant la démarche des patients. Des alternatives à une telle analyse sont les systèmes basés sur les marqueurs et les systèmes basés sur les plates-formes au sol. Cependant, cette analyse standard de la marche nécessite des laboratoires spécialisés, des équipements coûteux et de longs délais d’installation et de post-traitement. Les chercheurs ont fait de nombreuses tentatives pour proposer une alternative basée sur la vision par ordinateur pour l’analyse de la demarche. Avec l’apparition de caméras 3D bon marche, le problème de l’évaluation qualitative de la démarche a été re-examiné. Les chercheurs ont réalisé le potentiel des dispositifs de cameras 3D pour les applications d’analyse de mouvement. Cependant, malgré des progrès très encourageants dans les technologies de détection 3D, leur utilisation réelle dans l’application clinique reste rare. Cette thèse propose des modèles et des techniques pour l’évaluation du mouvement à l’aide d’un capteur Microsoft Kinect. En particulier, nous étudions la possibilité d’utiliser différentes données fournies par une caméra RGBD pour l’analyse du mouvement et de la posture. Les principales contributions sont les suivantes. Nous avons réalisé une étude de l’etait de l’art pour estimer les paramètres importants de la démarche, la faisabilité de différentes solutions techniques et les méthodes d’évaluation de la démarche existantes. Ensuite, nous proposons un descripteur de posture basé sur un nuage de points 3D. Le descripteur conçu peut classer les postures humaines statiques a partir des données 3D. Nous construisons un système d’acquisition à utiliser pour l’analyse de la marche basée sur les donnees acquises par un capteur Kinect v2. Enfin, nous proposons une approche de détection de démarche anormale basée sur les données du squelette. Nous démontrons que notre outil d’analyse de la marche fonctionne bien sur une collection de données personnalisées et de repères existants. Notre méthode d’évaluation de la démarche affirme des avances significatives dans le domain, nécessite un équipement limité et est prêt à être utilisé pour l’évaluation de la démarche.

Co-encadré avec : Albert Dipanda

Thèse soutenue le : 19 novembre 2018

Kyis ESSMAEEL

Titre : Interprétation et analyse du mouvement humain sans marqueur par stéréovision active

Sujet : Réalisation d’une plate-forme d’acquisition d’images permettant de suivre les déplacements d’un sujet humain dans une pièce. L’objectif est de calculer certains paramètres globaux de mouvement, mais aussi de pouvoir activer des alarmes en fonction de certaines situations ou scénarii caractéristiques. Cette plateforme pourra servir pour la surveillance des malades (de type Alzheimer) mais aussi dans le cadre d’activités telles que la rééducation fonctionnelle ou la décomposition des mouvements des sportifs.

Co-encadré avec : Albert Dipanda

Thèse soutenue le : 10 décembre 2015

HTBA – International Workshop on Human Tracking and Behavior Analysis

Le workshop HTBA propose depuis 2016 une rencontre autour l’analyse du comportement humain à partir de la vision par ordinateur.

Il est chaque année organiser conjointement à la conférence SITIS – International Conference on SIGNAL IMAGE TECHNOLOGY & INTERNET BASED SYSTEMS.

Champs d’étude du workshop

Le traitement des vidéos pour analyser le geste humain est un sujet brûlant et prometteur puisqu’il a été adopté dans de nombreuses applications telles que la surveillance vidéo, la surveillance médicale, la réalité virtuelle, l’interaction homme-machine, etc. La classe des personnes est au cœur des préoccupations de la recherche et de l’industrie et ouvre la voie vers l’intelligence artificielle. Comment un ordinateur peut-il faire la même interprétation d’une scène qu’un humain? Les possibilités sont infinies mais dépendent de l’efficacité des processus primaires : analyser et reconnaître les gestes et les comportements humains.

Ce workshop a pour objectif d’analyser les différentes significations, supports (capteurs 2D ou 3D) et contraintes (temps réel) qui permettent de répondre aux trois étapes principales de cette problématique : suivi, description et apprentissage. Les processus appliqués doivent être adaptés à la classe particulièrement complexe des personnes. La manière de suivre le mouvement, de décrire le geste et de reconnaître les comportements à différents niveaux (corps entier, jambes, main, etc.) sera mis en avant.

Thématiques du workshop

– Suivi de la position d’une ou plusieurs personnes

– Suivi de la pose d’une personne

– Video surveillance

– Applications médicales

– Reconnaissance de l’acte d’achat

– Analyse du mouvement 2D et 3D

– Reconnaissance de démarches

– Classification et apprentissage des actions

– Interfaçage avec des jeux-vidéos

– Implémentation légère pour système embarqué

– Traitement temps-réel

– Animation d’avatar

– Intégration du geste dans un environnement de réalité virtuel

– Analyse de vidéos de profondeur

– Suivi de la main

– Détection de personnes

– Reconnaissance des expressions faciales.

Précédentes éditions

Articles récents

– Estimation of Scenes Contributing to Score in Tennis Video using Attention, Ryunosuke Kurose, Masaki Hayashi and Yoshimitsu Aoki (HTBA 2018)

– Action and intention recognition of pedestrians in urban traffic, Dimitrios Varytimidis, Fernando Alonso-Fernandez, Cristofer Englund and Boris Duran (HTBA 2018)

– Machine Learning for Video Action Recognition: a Computer Vision Approach Mikel Labayen, Naiara Aginako, Basilio Sierra, Igor G. Olaizola and Julián Floréz (HTBA 2018)

– Kinematic Covariance Based Abnormal Gait Detection, Margarita Khokhlova (HTBA 2018)

– Pholder: An Eye-Gaze assisted reading application on Android, Christiantia Wirawan, Hu Qingyao, Liu Yi, Senglidet Yean, Bu-Sung Lee, Fang Ran (HTBA 2017)

– Occupancy Analysis of Soccer Fields using Wide-Angle lens, Noor Ul Huda, Rikke Gade, Thomas B. Moeslund (HTBA 2017)

– Tracking Hands in Interaction with Objects: A Review, Ammar Ahmad (HTBA 2017)

– Automatic analysis of activities in sports arenas using thermal cameras, Rikke Gade, Thomas B. Moeslund (HTBA2016)

– Motion Analysis for Cooking Motion Recognition, Yuma Hijioka, Makoto Murakami, Tadahiko Kimoto (HTBA2016)

– An Approach for the Evaluation of Sleeping Behaviors Disorders in Patients with Cognitive Diseases: A Case Study, Antonio Coronato, Giovanni Paragliola (HTBA2016)

– Action Recognition Online with Hierarchical Self-Organizing Maps, Zahra Gharaee, Peter Gardenfors, Magnus Johnsson (HTBA2016)

– Tracking People in Dense Crowds using Supervoxels Shota Takayama, Teppei Suzuki, Yoshimittsu Aoki, Sho Isobe, Makoto Masuda(HTBA2016)

– Conversational group detection based on social context using graph clustering algorithm, Shoichi Inaba, Yoshimitsu Aoki (HTBA2016)

– 3D Visual-based Human Motion Descriptors: A Review, Margarita Khokhlova, Cyrille Migniot, Albert Dipanda (HTBA2016)

Special issue Sensors : Human Activity Recognition Based on Image Sensors and Deep Learning

Il s’agit d’un special issue de la revue Sensors (ISSN 1424-8220) appartenant à la section Sensing and Imaging.

Editeurs : Fakhreddine Ababsa et Cyrille Migniot

Date limite de soumission : 21 mai 2021